Das System bietet eine innovative Steuerung mehrerer Bildschirme durch den Einsatz von Handgesten.

Zeigt man mit der Hand eine "1", wechselt das System zum ersten Bildschirm.

Eine "2" ruft den zweiten Bildschirm auf, eine "3" den dritten, und eine "4" den vierten Bildschirm.

Auf den Bildschirmen 1 bis 3 kann eine spezielle Geste, bei der die Fingerspitze den Daumen berührt, verwendet werden, um dynamische Aktionen auszuführen.

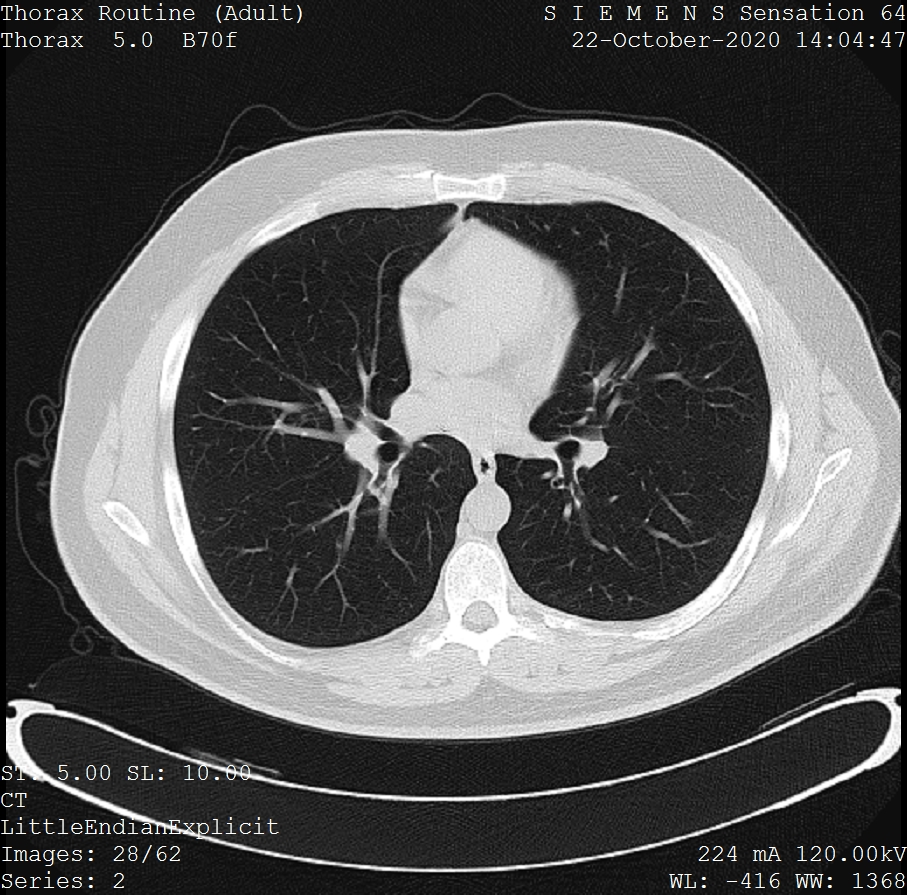

Diese Aktionen umfassen beispielsweise das Bewegen von Bildern oder das Navigieren durch einen CT-Scan.

Besonders auf dem dritten Bildschirm wird eine dreidimensionale Darstellung visualisiert, welche in der aktuellen Version der Benutzeroberfläche durch ein Teekannenmodell repräsentiert wird.

Zusätzlich zeigt die Benutzeroberfläche wichtige Informationen, wie Patientendaten, auf der linken Seite und die Vitalwerte auf der rechten Seite an.

Unten rechts wird die erkannte Geste angezeigt, zusammen mit der Wahrscheinlichkeit, mit der die Geste erkannt wird.

In der Web-Demo kann die erkannte Geste durch das Klicken auf entsprechende Buttons simuliert werden, wodurch die Geste angezeigt wird, die man im eigentlichen Programm mit der Hand ausführen würde.

The system offers innovative control of multiple screens using hand gestures.

Displaying the hand gesture for "1" switches the system to the first screen, "2" brings up the second screen, "3" the third, and "4" the fourth screen.

On screens 1 through 3, a special gesture, where the fingertip touches the thumb, can be used to perform dynamic actions.

These actions include, for example, moving images or navigating through a CT scan.

Notably, on the third screen, a three-dimensional representation is visualized, which in the current version of the user interface is represented by a teapot model.

Additionally, the user interface displays important information, such as patient data on the left side and vital signs on the right side.

The recognized gesture is shown at the bottom right, along with the probability of gesture recognition.

In the web demo, the recognized gesture can be simulated by clicking the corresponding buttons, which shows the gesture that would be performed with the hand in the actual program.